La última semana en el mundo de la inteligencia artificial (IA) ha sido muy movida, incluso para los estándares de la tecnología. El 17 de noviembre, el directorio de Openai echó a Sam Altman, el líder del fabricante del Chatgpt.

El 20 de noviembre, Altman ya se había refugiado en Microsoft, el mayor patrocinador de la startup. Ese mismo día, casi todos los 770 empleados de Openai firmaron una carta en la que amenazaban con dimitir, a menos que los miembros del directorio que destituyeron a Altman lo reincorporaran y presentaran ellos mismos su renuncia. El 21 de noviembre, Altman volvía a su antiguo puesto.

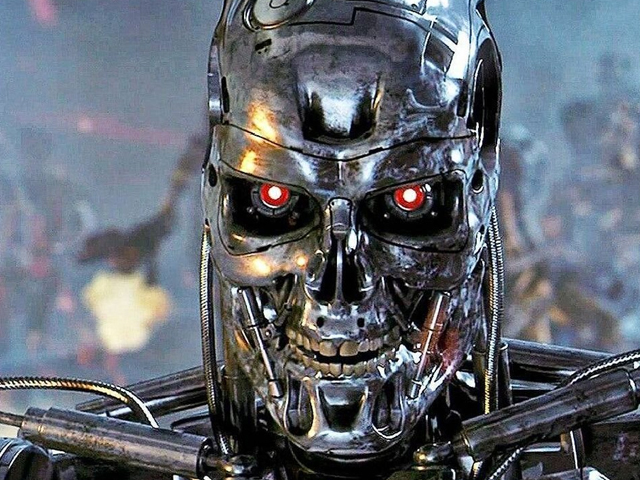

Lo ocurrido en Openai es una muestra clara de una división más amplia en Silicon Valley. Por un lado, están los “catastrofistas”, que creen que, si no se controla, la IA supone un riesgo existencial para la humanidad y, por tanto, abogan por una regulación más estricta (los “doomers”).

Frente a ellos están los “boomers“, que restan importancia a los temores de un apocalipsis de la IA y subrayan su potencial para impulsar el progreso.

Altman parecía simpatizar con ambos grupos, pidiendo públicamente “controles de seguridad” para que la IA fuera segura, al tiempo que empujaba a Openai a desarrollar modelos más potentes y a lanzar nuevas herramientas, como una tienda de aplicaciones para que los usuarios construyeran sus propios chatbots.

Hoy parece decididamente más boomer, al igual que la mayoría de los empleados de Openai que querían su vuelta.

Eso preocupará a los políticos, que se apresuran a demostrar que se toman en serio los riesgos. En julio, la administración del Presidente Joe Biden instó a siete de los principales fabricantes de modelos, entre ellos Google, Meta, Microsoft y Openai, a que asumieran “compromisos voluntarios” para que sus productos IA fueran inspeccionados por expertos antes de ponerlos a disposición del público.

El 1 de noviembre, el Gobierno británico consiguió que un grupo similar firmara otro acuerdo no vinculante que permitía a los reguladores comprobar la fiabilidad de sus modelos de inteligencia artificial y sus capacidades nocivas, como poner en peligro la seguridad nacional.

Días antes, Biden emitió una orden ejecutiva más contundente. Obliga a cualquier empresa de IA que elabore modelos que superen un determinado tamaño -definido por la potencia de cálculo necesaria- a notificarlo al gobierno y compartir los resultados de sus pruebas de seguridad.